File robots.txt tuy không phải là không thể thiếu, tuy nhiên là một trong những thành phần quan trọng đối với một website. Vậy cụ thể File robots.txt được sử dụng để làm gì? Quản lý như thế nào cho hiệu quả? Và cách tạo ra sao? Tìm hiểu chi tiết ngay sau đây!!!

Nội dung chính

File robots.txt là gì?

File robots.txt là tệp chứa các chỉ thị cho các công cụ tìm kiếm. Robots.txt cho các công cụ tìm kiếm biết quy tắc tương tác của trang web là gì. Một phần quan trọng của việc làm SEO là gửi các tín hiệu phù hợp đến các công cụ tìm kiếm và robots.txt là một trong những cách để truyền đạt các tùy chọn thu thập thông tin tới các công cụ tìm kiếm.

Các công cụ tìm kiếm thường xuyên kiểm tra tệp robots.txt của trang web để xem liệu có bất kỳ hướng dẫn nào để thu thập thông tin trang web hay không.

Khi nào cần file robots.txt?

- Khi bạn muốn duy trì quyền riêng tư của một số phần của trang web, vì đó là trang thử nghiệm.

- Để tránh nội dung trùng lặp xuất hiện trên trang kết quả của Google

- Khi bạn không muốn các trang kết quả tìm kiếm nội bộ xuất hiện trên trang kết quả công khai .

- Để xác định vị trí của sitemap

- Để ngăn các công cụ tìm kiếm lập chỉ mục các tệp nhất định trên trang web.

- Để chỉ ra độ trễ thu thập thông tin để tránh quá tải máy chủ khi trình thu thập thông tin tải nhiều phần nội dung cùng một lúc.

Cấu trúc của file robots.txt

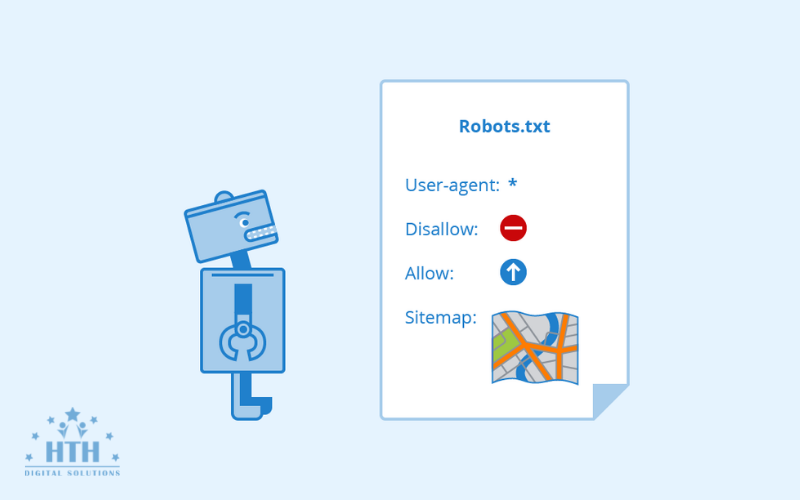

Các cú pháp được xem là ngôn ngữ riêng của các tập tin robots.txt. Có 5 thuật ngữ phổ biến mà bạn sẽ bắt gặp trong một file robots.txt là gì? Chúng bao gồm:

- User-agent: Tên của các trình thu thập, truy cập dữ liệu web. (ví dụ: Google Bot, Bing Bot,…)

- Disallow: Thành phần này được sử dụng để thông báo cho các user-agent không thu thập bất kỳ dữ liệu URL cụ thể nào. Mỗi URL chỉ được sử dụng 1 dòng Disallow.

- Allow (chỉ áp dụng cho Google Bot): Lệnh thực hiện thông báo cho Google Bot rằng nó sẽ truy cập một trang hoặc thư mục con. Mặc dù các trang hoặc các thư mục con của nó có thể không được phép.

- Crawl-delay: Thông báo cho các web crawler biết rằng nó phải đợi bao nhiêu giây trước khi tải và thu thập nội dung của trang. Tuy nhiên, lưu ý rằng Google Bot không thừa nhận lệnh này. Bạn có thể cài đặt tốc độ thu thập dữ liệu trong Google Search Console.

- Sitemap: Được sử dụng để cung cấp các vị trí của bất kì Sitemap XML nào được liên kết với URL này. Lưu ý lệnh này chỉ được hỗ trợ bởi công cụ Google, Ask, Bing và Yahoo.

Định dạng cơ bản:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Ví dụ:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Sitemap: https://example.com/sitemap_index.xml

Cách quản lý các tệp robots.txt hiệu quả

Không chặn nội dung bạn muốn được theo dõi

Không nên chặn các phần của trang web cần được theo dõi. Hãy lưu ý rằng các Bot sẽ không theo liên kết của các trang bị robots.txt chặn.

Tuy nhiên trừ khi chúng cũng được liên kết từ các trang khác mà công cụ tìm kiếm có thể truy cập vì chúng chưa bị chặn; các tài nguyên được liên kết sẽ không được thu thập thông tin và có thể không được lập chỉ mục. Ngoài ra, không có giá trị liên kết nào có thể được chuyển từ trang bị chặn đến đích liên kết.

Không sử dụng robots.txt để tránh hiển thị dữ liệu bí mật trên trang kết quả của công cụ tìm kiếm

Các trang khác có thể liên kết trực tiếp đến trang chứa thông tin bí mật (do đó tránh được các nguyên tắc robots.txt), đó là lý do tại sao nó vẫn có thể được lập chỉ mục.

Bạn nên sử dụng một phương pháp khác, chẳng hạn như bảo vệ bằng mật khẩu hoặc thẻ meta ngăn lập chỉ mục, để ngăn trang xuất hiện trong kết quả tìm kiếm của Google.

Khai báo URL robots.txt với Google khi thay đổi

Công cụ tìm kiếm lưu trữ nội dung của tệp robots.txt nhưng thường cập nhật dữ liệu đã lưu trong bộ nhớ cache hàng ngày. Nếu bạn thay đổi tệp và muốn cập nhật tệp nhanh hơn, bạn có thể gửi URL robots.txt tới Google.

Cách tạo file robots.txt WordPress

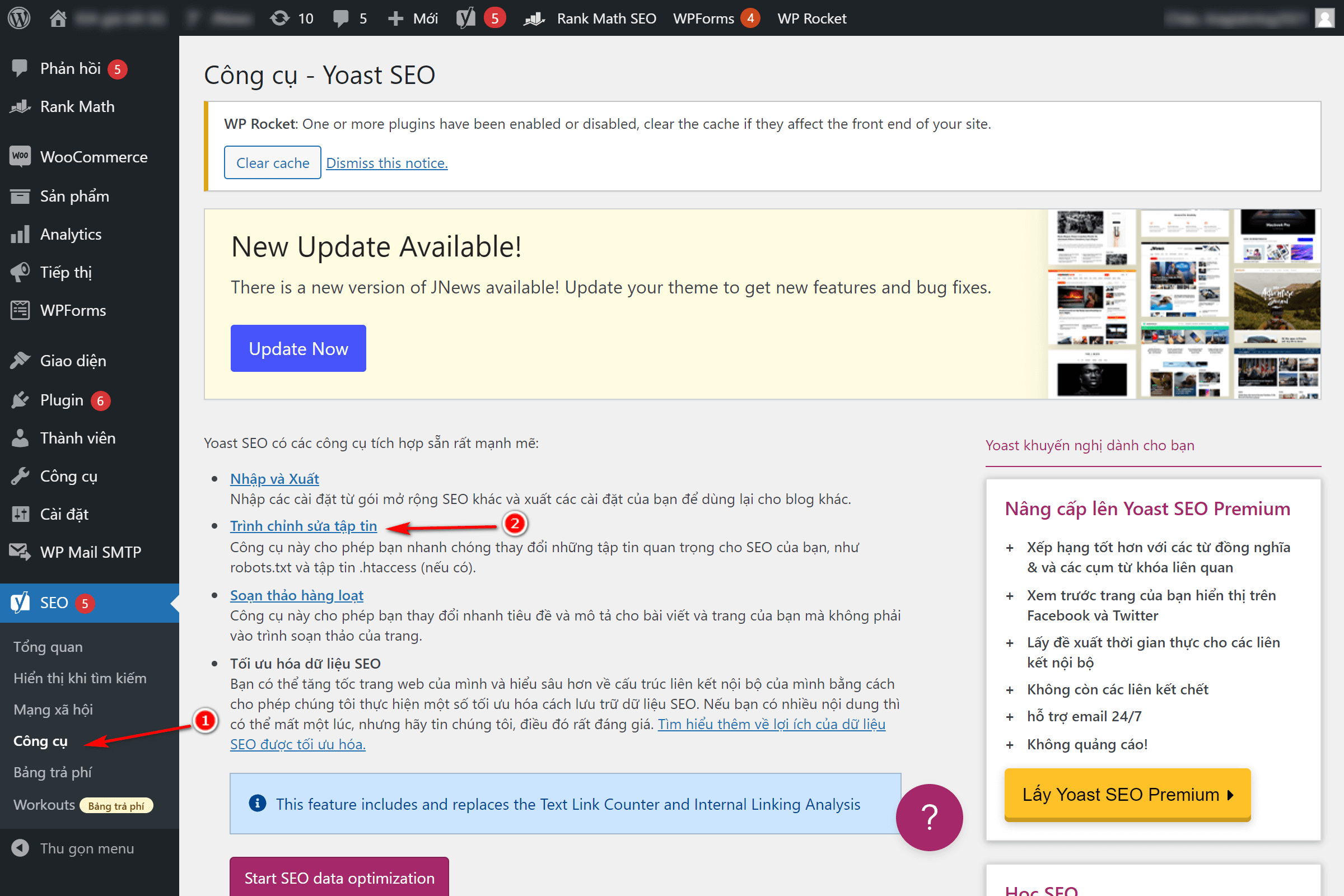

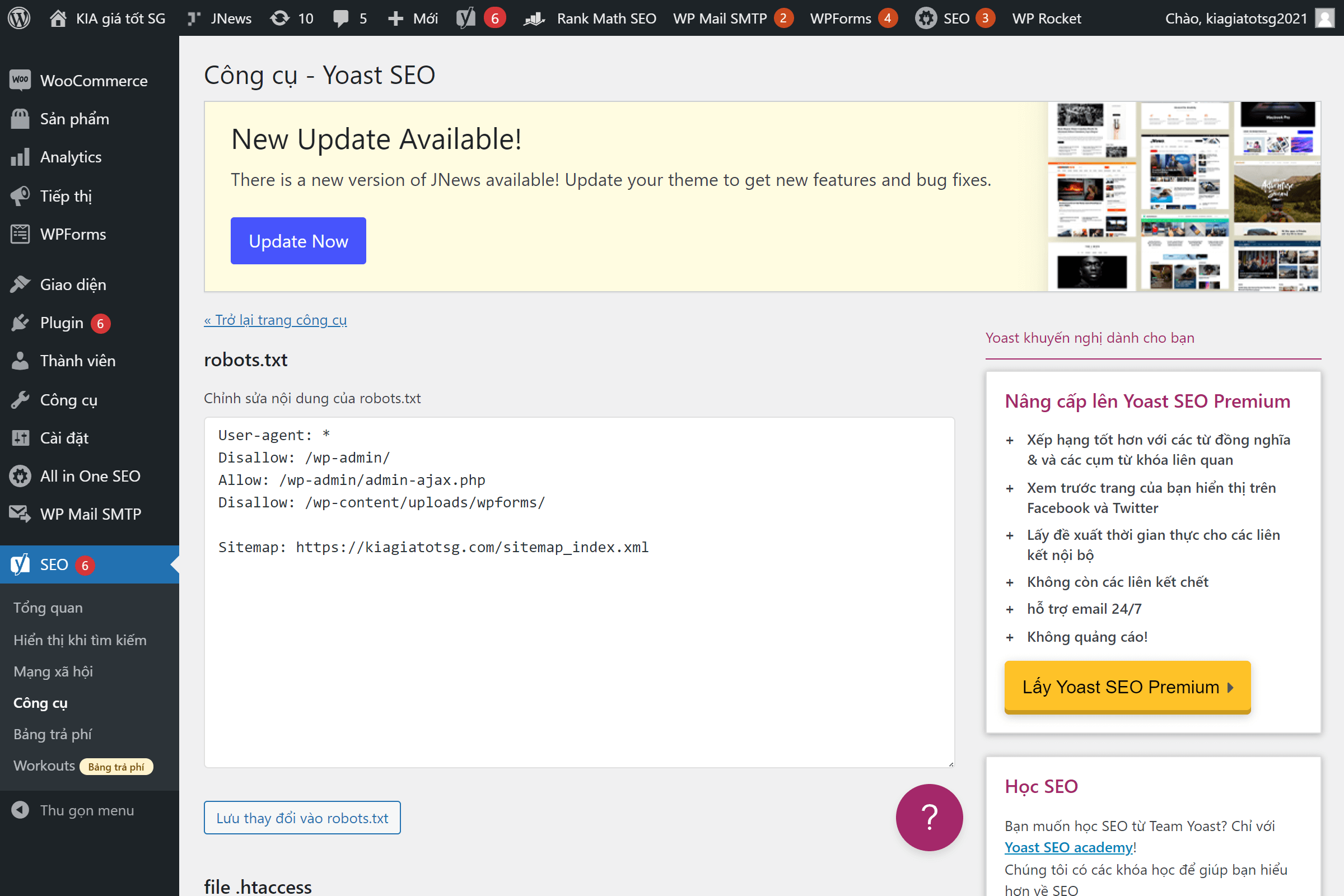

1. Tạo file robots.txt với Yoast SEO ?

Tại giao diện quản trị website (Dashboard) » Plugins » Add new.

Sau đó chọn SEO » Tools.

Nhấn chọn File Editor, tiếp tục nhấn Lưu thay đổi vào robots.txt để hoàn tất quá trình tạo file hoặc chỉnh sửa robots.txt.

Sau đó bấm Lưu lại.

Và trên đây là một số thông tin về File robots.txt. Hy vọng bài viết này đầy đủ những thông tin mà bạn mong muốn, chúc bạn áp dụng thành công.